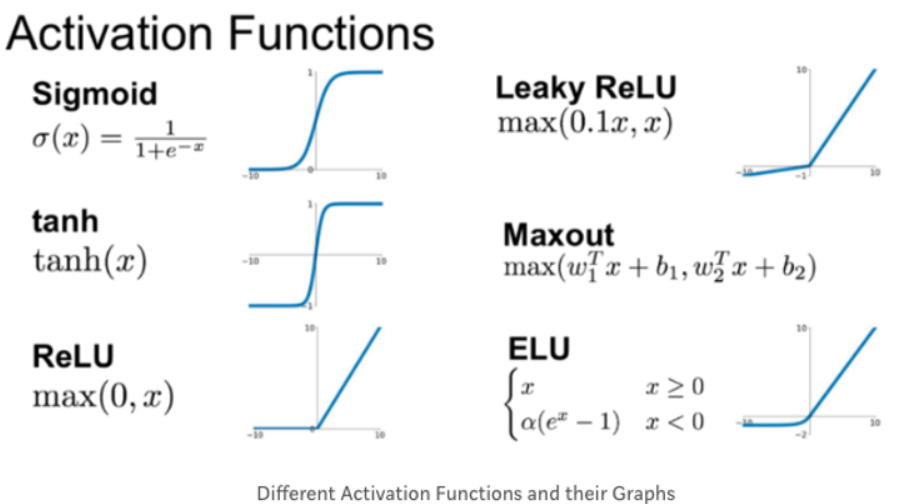

점프렐루 SAE(JumpReLU SAE)는 기존의 희소 오토인코더(Sparse Autoencoder, SAE) 아키텍처를 개선하여 LLM의 내부 작동 방식을 해석하는 데 도움을 주는 새로운 아키텍처이다. 이 아키텍처는 기존의 ReLU(렐루) 함수 대신 점프렐루(JumpReLU) 함수를 사용하여 각 뉴런에 대해 개별적인 임계값을 지정하는 방식을 채택했다.

기본 원리

점프렐루 SAE는 다음과 같은 방식으로 작동한다:

1. 입력 인코딩: 입력 데이터를 중간 표현으로 인코딩한다. 이 과정에서 각 뉴런은 특정 임계값을 초과해야만 활성화된다.

2. 희소성 강제: 점프렐루 함수는 각 뉴런에 대해 별도의 임계값을 지정하여, 활성화 값이 임계값 이하인 모든 특징을 0으로 만든다. 이를 통해 불필요한 뉴런의 활성화를 줄이고, 중요한 특징만을 남긴다.

3. 재구성: 인코딩된 중간 표현을 원래의 입력 데이터로 디코딩한다. 이 과정에서 원래의 활성화 상태와 재구성된 활성화 상태 간의 차이를 최소화하는 것을 목표로 한다.

점프렐루 함수의 특징

점프렐루 함수는 각 뉴런에 대해 개별적인 임계값을 지정함으로써, 다음과 같은 장점을 제공한다:

- 동적 임계값 설정: 전역 임계값을 사용하는 기존의 SAE와 달리, 점프렐루는 뉴런마다 다른 임계값을 설정하여 더 유연한 활성화 제어가 가능하다.

- 희소성 및 재구성 충실도 균형: 희소성(sparsity)과 재구성 충실도(reconstruction fidelity) 사이의 균형을 더 잘 맞출 수 있다. 이는 활성화되지 않는 ‘죽은 특징’을 최소화하고, 과도하게 활성화된 특징도 줄이는 데 효과적이다[1][2].

훈련 방법

점프렐루 SAE의 훈련은 다음과 같은 과정을 따른다:

1. 손실 함수: 점프렐루 SAE는 L0 희소성 페널티를 포함한 손실 함수를 사용한다. 이는 뉴런의 활성화를 최소화하면서도 중요한 정보를 유지하는 데 도움을 준다.

2. 직접 통과 추정기(STE): L0 희소성 페널티는 임계값에 대한 그래디언트 신호를 제공하지 않기 때문에, 직접 통과 추정기(Straight-Through Estimator, STE)를 사용하여 임계값을 훈련한다. 이는 임계값을 효과적으로 조정하여 희소성과 재구성 충실도 사이의 균형을 맞추는 데 도움을 준다[1].

비교 및 평가

연구진은 점프렐루 SAE를 구글의 ‘젬마 2 9B’ LLM에 적용하여, 기존의 게이티드 SAE(Gated SAE)와 오픈AI의 톱K SAE(TopK SAE)와 비교했다. 그 결과, 점프렐루 SAE는 다양한 희소성 수준에서 재구성 충실도가 게이티드 SAE보다 우수했으며, 톱K SAE와는 최소한 동등한 수준으로 나타났다. 특히 점프렐루 SAE는 활성화되지 않는 ‘죽은 특징’을 최소화하는 데 매우 효과적이었다[2][3].

결론

점프렐루 SAE는 기존의 SAE 아키텍처를 개선하여 LLM의 내부 작동 방식을 더 잘 해석할 수 있도록 돕는다. 이를 통해 LLM의 행동을 원하는 방향으로 조종하거나, 편견이나 독성을 완화하는 기술 개발에도 기여할 수 있다.

Citations:

[1] https://arxiv.org/html/2407.14435v1

점프렐루 SAE의 작동 방식 : 씽크탱크 | 도큐멘토

점프렐루 SAE(JumpReLU SAE)는 기존의 희소 오토인코더(Sparse Autoencoder, SAE) 아키텍처를 개선하여 LLM의 내부 작동 방식을 해석하는 데 도움을 주는 새로운 아키텍처이다. 이 아키텍처는 기존의 ReLU(렐

www.documento.co.kr

'PLAN Insight' 카테고리의 다른 글

| 나라장터 제안서 작성법 : 제안요청서 및 제안 목차 (0) | 2024.08.05 |

|---|---|

| 구글, LLM 해석 가능한 새로운 아키텍처 발표 (0) | 2024.08.01 |

| 딥페이크(Deepfake) 기술: 양날의 검 (1) | 2024.07.29 |

| 외국에는 기획자라는 직업이 있을까? 제안서 작성하는 사람은? (0) | 2024.07.28 |

| 나라장터 입찰 제안서 작성 시 가장 흔히 저지르는 실수 (0) | 2024.07.27 |