LLM의 크기와 양자화의 필요성

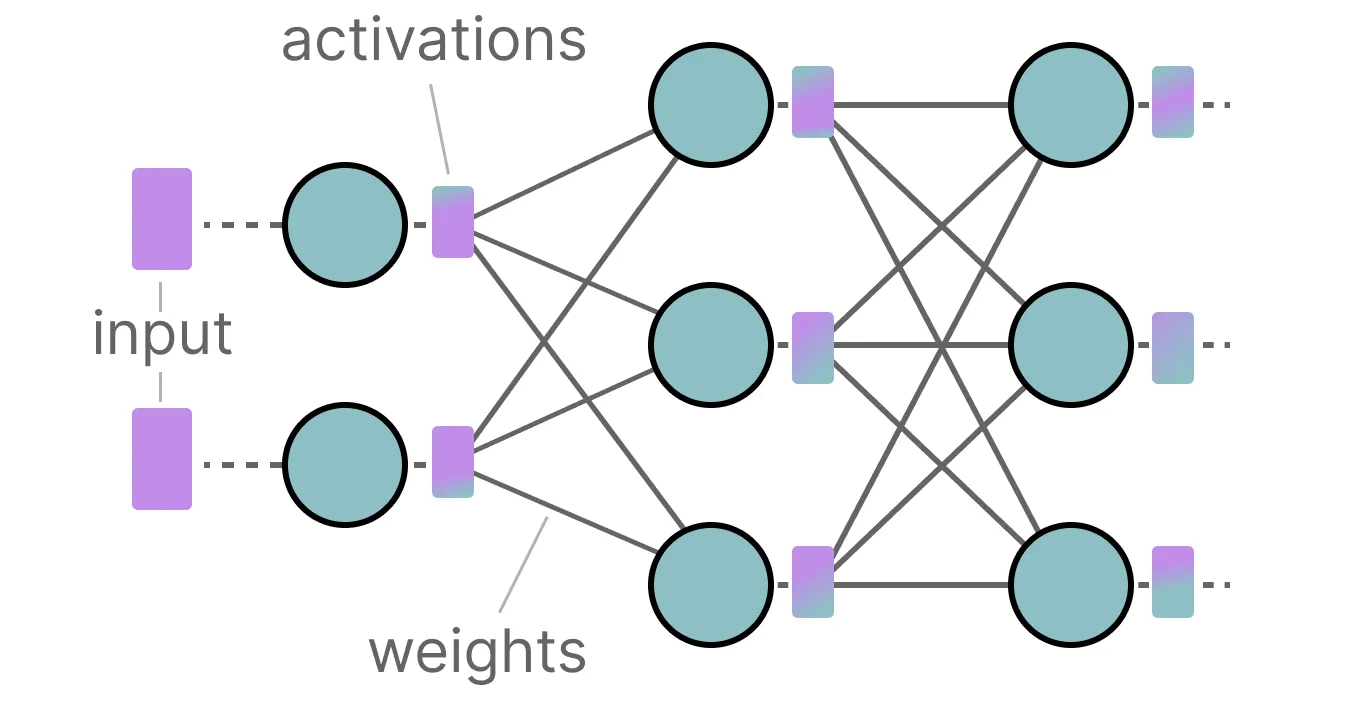

대규모 언어 모델(LLM)은 그 이름에서 알 수 있듯이 매우 큰 규모를 자랑합니다. 이러한 모델들은 수십억 개의 매개변수를 가지고 있어, 일반적인 소비자용 하드웨어에서 실행하기가 매우 어렵습니다. 대부분의 LLM은 대용량 VRAM을 갖춘 GPU가 필요하여 추론 속도를 높일 수 있습니다.

이러한 문제를 해결하기 위해 연구자들은 모델을 더 작게 만드는 데 초점을 맞추고 있습니다. 이 분야에서 주요한 기술 중 하나가 바로 '양자화(Quantization)'입니다.

양자화란 무엇인가?

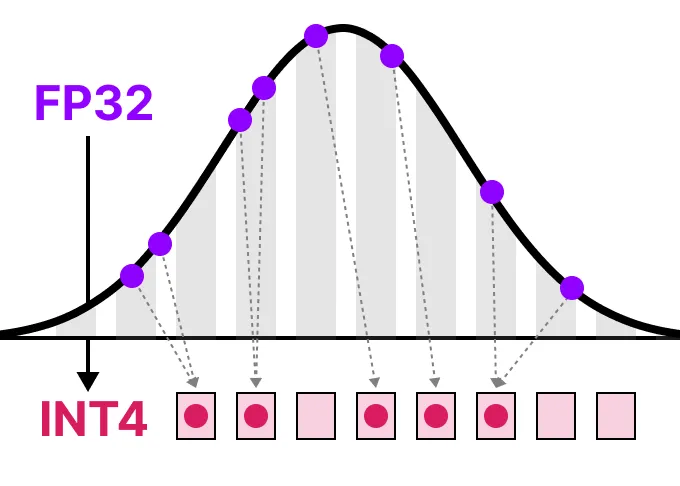

양자화는 모델의 매개변수 정밀도를 낮추는 기술입니다. 일반적으로 32비트 부동소수점(FP32)에서 더 낮은 비트 폭(예: 8비트 정수)으로 줄이는 과정을 말합니다. 이는 마치 고해상도 이미지를 더 적은 색상으로 표현하는 것과 유사합니다.

주요 데이터 유형

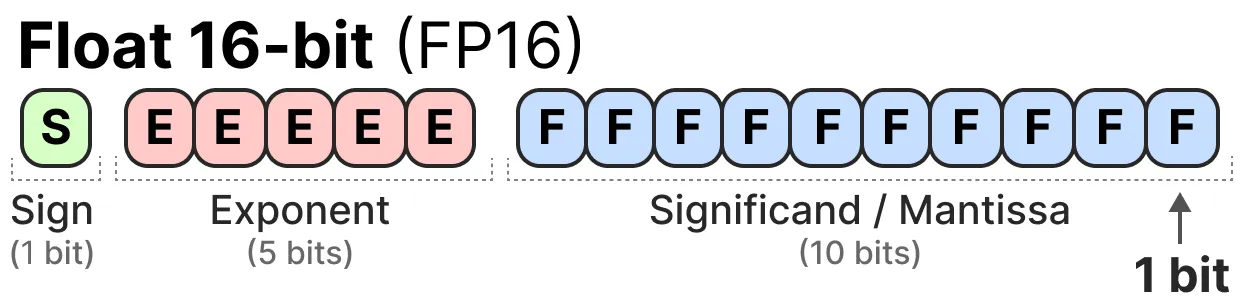

1. FP16 (반정밀도): 32비트에서 16비트로 줄임

2. BF16 (브레인 부동소수점): FP32와 유사한 범위를 가지지만 16비트만 사용

3. INT8 (8비트 정수): 부동소수점에서 정수 기반 표현으로 전환

양자화 방법

1. 대칭 양자화: 원래 부동소수점 값의 범위를 0을 중심으로 대칭적인 범위로 매핑합니다.

2. 비대칭 양자화: 최소값과 최대값을 양자화된 범위의 최소값과 최대값에 매핑합니다.

양자화 기법

사후 훈련 양자화 (PTQ)

- 모델 훈련 후 적용

- 동적 양자화: 추론 중 각 레이어마다 양자화 수행

- 정적 양자화: 미리 계산된 값을 사용하여 양자화

양자화 인식 훈련 (QAT)

- 훈련 중 양자화 고려

- 일반적으로 PTQ보다 정확도가 높음

고급 양자화 방법

1. GPTQ:

- 4비트 양자화에 널리 사용

- 레이어별로 독립적으로 처리

- 역 헤시안 행렬을 사용하여 가중치의 중요도 평가

2. GGUF:

- CPU와 GPU를 함께 사용 가능

- 블록 단위로 가중치 분할 및 양자화

BitNet: 1비트 LLM의 혁신

BitNet은 모델의 가중치를 단 1비트(-1 또는 1)로 표현하는 혁신적인 접근법입니다. 이는 트랜스포머 아키텍처에 직접 양자화 과정을 주입하여 구현됩니다.

BitNet 1.58b:

- 가중치를 -1, 0, 1의 세 가지 값으로 표현

- 행렬 곱셈을 단순 덧셈으로 대체하여 계산 속도 향상

- 0을 사용하여 특성 필터링 가능

결론

양자화는 LLM의 크기를 줄이고 효율성을 높이는 중요한 기술 분야입니다. 다양한 방법과 접근법이 계속해서 연구되고 있으며, 이를 통해 더 작고 빠른 모델을 만들 수 있게 되었습니다. 앞으로도 이 분야에서 많은 혁신이 이루어질 것으로 예상됩니다.

Citations:

대규모 언어 모델(LLM)의 양자화: 효율성과 성능의 균형 : 씽크탱크 | 도큐멘토

LLM의 크기와 양자화의 필요성대규모 언어 모델(LLM)은 그 이름에서 알 수 있듯이 매우 큰 규모를 자랑합니다. 이러한 모델들은 수십억 개의 매개변수를 가지고 있어, 일반적인 소비자용 하드웨어

www.documento.co.kr

'ThinkTank' 카테고리의 다른 글

| NVIDIA 젠슨 황과 Meta 마크 저커버그가 말하는 AI 혁신 (0) | 2024.08.01 |

|---|---|

| 온디바이스 AI의 진화: 글로벌 기업들의 최신 동향 (0) | 2024.08.01 |

| AI가 기획자 역할을 대체할 수 있을까 (0) | 2024.07.30 |

| 얼굴 표정만으로 수술 후 통증 예측하는 AI 개발 (0) | 2024.07.17 |

| 엔비디아, 아마존이 투자한 Perplexity (0) | 2024.07.14 |